Hast du schon einmal erlebt, dass eine Künstliche Intelligenz (KI) etwas völlig Falsches behauptet hat? Vielleicht hat ein Sprachmodell eine Antwort gegeben, die keinen Sinn ergab, oder ein Bildgenerator hat Dinge hinzugefügt, die nicht da sein sollten. Solche Phänomene nennt man „KI-Halluzinationen“.

Sie treten auf, wenn eine KI scheinbar aus dem Nichts Informationen erschafft oder bestehende Daten falsch interpretiert. In diesem Artikel erfährst du, was hinter diesen irreführenden Ergebnissen steckt und warum es wichtig ist, sie zu verstehen. Denn nur wenn du die Ursachen kennst, kannst du verhindern, dass dich KI in die Irre führt.

Inhalt

Was sind KI-Halluzinationen?

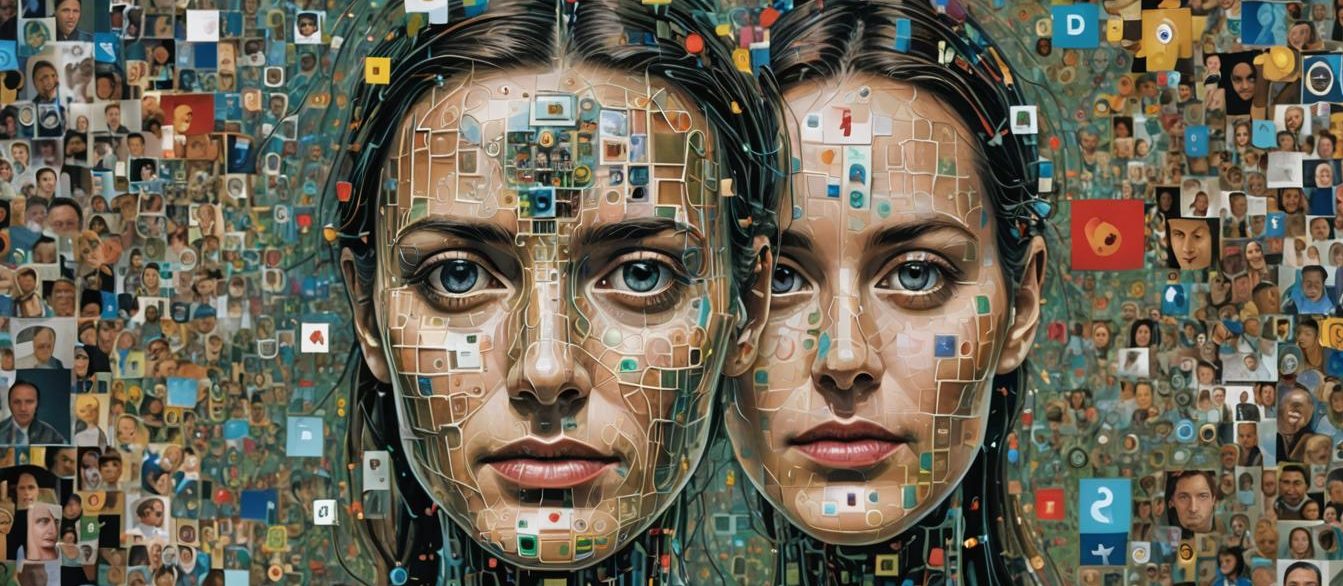

KI-Halluzinationen treten auf, wenn eine KI falsche oder irreführende Informationen generiert, die keinen Bezug zur Realität haben. Zum Beispiel kann ein Sprachmodell erfundene Fakten präsentieren oder ein Bildgenerator Objekte darstellen, die nie existiert haben. Diese „Halluzinationen“ entstehen oft durch Lücken in den Trainingsdaten oder durch Fehlinterpretationen der vorhandenen Informationen.

KI-Halluzinationen bezeichnen das Phänomen, bei dem eine Künstliche Intelligenz falsche oder irreführende Informationen generiert, die keinen Bezug zur Realität haben. Diese „Halluzinationen“ entstehen, wenn die KI über die Daten hinausgeht, die ihr zur Verfügung stehen, und eigenständig etwas erfindet. Das kann in vielen Formen auftreten, wie etwa falsche Fakten in Texten, erfundene Objekte in Bildern oder widersprüchliche Antworten in Konversationen.

Beispiele für KI-Halluzinationen:

Medizinische Diagnosen: In einem medizinischen Kontext könnte eine KI Symptome falsch interpretieren und eine Diagnose stellen, die weder durch die vorhandenen Daten noch durch medizinisches Wissen gestützt wird.

Sprachmodelle: Eine KI könnte auf die Frage „Wer hat 1962 den Nobelpreis für Mathematik gewonnen?“ eine Antwort geben, obwohl es diesen Preis in der Kategorie Mathematik nie gegeben hat. Hier erfindet die KI eine Antwort, um die Frage zu „beantworten“.

Bilderkennung: Ein Bildgenerator kann versuchen, eine Katze auf einem Bild zu „erkennen“ und fügt dann auf unerklärliche Weise Katzengesichter in zufällige Objekte ein.

Warum ist es wichtig, das zu verstehen?

KI-Halluzinationen können erhebliche Konsequenzen haben, insbesondere wenn es um wichtige Entscheidungen geht, die auf KI-Ergebnissen basieren. Missverständnisse können zu falschen Diagnosen, fehlerhaften Vorhersagen oder gefährlichen Fehlfunktionen führen. Wenn du weißt, wie und warum diese Phänomene auftreten, kannst du besser einschätzen, wann du KI-Ergebnissen vertrauen kannst – und wann nicht.

Warum liefert KI manchmal irreführende oder falsche Ergebnisse?

KI-Systeme basieren auf statistischen Modellen, die aus großen Mengen an Daten lernen. Wenn diese Daten unvollständig, verzerrt oder fehlerhaft sind, kann die KI falsche Muster erkennen und diese in ihre Ergebnisse einfließen lassen.

KI-Halluzinationen entstehen durch verschiedene Ursachen, die sich auf die Qualität und Verarbeitung der Daten sowie auf die Modellarchitektur beziehen. Hier ein Überblick über die wichtigsten Faktoren:

1. Datenmangel und falsche Trainingsdaten

- Datenmangel: Wenn eine KI mit unzureichenden Daten trainiert wird, kann sie keine verlässlichen Muster erkennen. Das führt dazu, dass sie bei unbekannten oder seltenen Eingaben versucht, Lücken durch „Raten“ zu füllen, was zu halluzinierten Ergebnissen führt.

- Falsche Trainingsdaten: Werden ungenaue oder fehlerhafte Daten verwendet, lernt die KI falsche Zusammenhänge. Wenn z. B. ein Sprachmodell mit unzuverlässigen oder erfundenen Informationen trainiert wird, wird es diese Fehler weitergeben und möglicherweise selbst neue erfinden.

2. Bias und Fehlinformationen in Trainingsdaten

- Bias (Verzerrungen): Daten können systematische Verzerrungen aufweisen, die durch kulturelle, soziale oder historische Faktoren bedingt sind. Eine KI, die auf solchen Daten trainiert wird, kann Vorurteile und Stereotype reproduzieren und verstärken, indem sie falsche oder unangemessene Schlüsse zieht.

- Fehlinformationen: Enthalten Trainingsdaten absichtlich oder unabsichtlich falsche Informationen, kann die KI

Auswirkungen von KI-Halluzinationen

1. Beispiele aus der Praxis

- Medizinische Diagnostik: Eine KI zur Bildanalyse kann in Röntgenbildern Anomalien „sehen“, die nicht existieren, und dadurch eine falsche Diagnose stellen. Dies könnte dazu führen, dass ein Patient unnötige Behandlungen erhält oder eine tatsächlich vorhandene Krankheit übersehen wird. Solche Fehlinterpretationen können schwerwiegende gesundheitliche Folgen haben.

- Autonome Fahrzeuge: In autonomen Fahrzeugen müssen KIs zuverlässig zwischen verschiedenen Objekten und Situationen unterscheiden

KI-Halluzinationen in Ergebnissen erkennen

Einige Tipps, wie du irreführende Informationen identifizieren kannst. Strategien, um die Zuverlässigkeit von KI-Ergebnissen zu überprüfen.

Diese Ansätze helfen dir, KI-Halluzinationen zu erkennen und die Zuverlässigkeit der Ergebnisse besser einzuschätzen.

Tipps, um irreführende Informationen zu identifizieren

- Vertraue deinem gesunden Menschenverstand: Wenn ein KI-Ergebnis merkwürdig oder unlogisch erscheint, überprüfe es kritisch. KI- Halluzinationen treten oft auf, wenn die Antworten ungewöhnlich präzise klingen, aber keine echten Belege oder Erklärungen bieten.

- Überprüfe Fakten und Quellen: Wenn eine KI Fakten oder Informationen liefert, vergleiche diese mit verlässlichen externen Quellen. KI-Modelle können erfundene Fakten mit überzeugendem Ton präsentieren, aber eine kurze Überprüfung kann helfen, solche Halluzinationen zu entlarven.

- Achte auf Unstimmigkeiten: Wenn die KI innerhalb einer Konversation widersprüchliche Aussagen macht oder plötzlich das Thema wechselt, ist Vorsicht geboten. Das kann ein Zeichen dafür sein, dass die KI „halluziniert“.

Strategien, um die Zuverlässigkeit von KI-Ergebnissen zu überprüfen

- Cross-Validation: Setze mehrere unabhängige KI-Modelle ein, um dieselbe Frage oder Aufgabe zu bearbeiten. Wenn die Ergebnisse stark voneinander abweichen, ist Vorsicht geboten.

- Human-in-the-Loop: Integriere menschliche Experten in den Prozess der Ergebnisbewertung. Lass Fachleute überprüfen, ob die von der KI generierten Informationen sinnvoll und korrekt sind.

- Vertrauensscore: Einige KI-Systeme bieten einen Vertrauensscore an, der anzeigt, wie sicher sich das Modell bei seiner Antwort ist. Nutze diesen Score, um die Qualität der Ergebnisse besser einzuschätzen.

Tools und Methoden, um KI-Ausgaben zu validieren

- Explainable AI (XAI) Tools: Verwende Tools, die die Entscheidungsprozesse der KI erklären. Sie zeigen, welche Datenpunkte das Modell für seine Entscheidung herangezogen hat, und helfen dabei, KI-Halluzinationen besser zu verstehen und zu erkennen.

- Adversarial Testing: Setze auf adversarielle Tests, um Schwachstellen im Modell zu identifizieren. Dabei werden bewusst irreführende oder ungewöhnliche Eingaben verwendet, um zu sehen, wie robust die KI reagiert.

- Automatische Faktenprüfung (Fact-Checking): Es gibt spezielle Tools, die KI-generierte Aussagen automatisch mit externen Fakten abgleichen und so die Richtigkeit der Informationen überprüfen.

Was du tun kannst, um KI-Halluzinationen zu minimieren

Wähle die richtigen Datenquellen und bereinige sie gründlich. Trainiere Modelle gezielt auf Genauigkeit und Verlässlichkeit. Setze auf transparente Modelle und Erklärbarkeit.

Mit diesen Maßnahmen kannst du die Wahrscheinlichkeit von KI-Halluzinationen deutlich reduzieren und gleichzeitig die Verlässlichkeit und Transparenz deiner Modelle erhöhen.

1. Wähle die richtigen Datenquellen und bereinige sie gründlich

- Verwende hochwertige und vielfältige Daten: Achte darauf, dass die Trainingsdaten umfassend und repräsentativ sind. Sammle Daten aus verschiedenen, vertrauenswürdigen Quellen, um ein möglichst vollständiges Bild zu erhalten. So reduzierst du das Risiko, dass die KI auf verzerrte oder ungenaue Informationen zurückgreift.

- Datenbereinigung: Entferne ungenaue, unvollständige oder widersprüchliche Daten aus dem Trainingssatz. Doppelte, fehlerhafte oder irrelevante Einträge können die Lernprozesse der KI negativ beeinflussen und zu Halluzinationen führen. Verwende Techniken wie Datenfilterung, Duplikaterkennung und Anomalieerkennung, um die Datenqualität zu verbessern.

- Achte auf Bias und Fehlinformationen: Identifiziere und beseitige Verzerrungen in den Daten. Verzerrte Trainingsdaten können dazu führen, dass die KI falsche Muster erkennt und irreführende Ergebnisse liefert. Nutze Techniken zur Bias-Erkennung und Fairness-Kontrolle, um die Integrität der Daten sicherzustellen.

2. Trainiere Modelle gezielt auf Genauigkeit und Verlässlichkeit

- Feintuning und spezifische Trainingsmethoden: Passe die Modelle an spezifische Aufgaben an und trainiere sie gezielt auf Genauigkeit und Verlässlichkeit. Je präziser das Modell auf bestimmte Kontexte abgestimmt ist, desto geringer ist die Wahrscheinlichkeit, dass es halluziniert.

- Regelmäßiges Retraining: Aktualisiere die Modelle regelmäßig mit neuen und relevanten Daten. Dies hilft, alte Muster zu korrigieren und das Modell an neue Informationen anzupassen. Ein kontinuierlicher Lernprozess minimiert die Wahrscheinlichkeit von Halluzinationen.

- Evaluierung und Tests: Teste das Modell kontinuierlich mit realen und adversariellen Daten, um seine Genauigkeit und Verlässlichkeit zu überprüfen. Setze auf Benchmarking und regelmäßige Performance-Überprüfungen, um sicherzustellen, dass das Modell robust und verlässlich bleibt.

3. Setze auf transparente Modelle und Erklärbarkeit

- Explainable AI (XAI): Nutze erklärbare KI-Modelle, die die Entscheidungsprozesse offenlegen. Transparente Modelle bieten Einblicke, wie und warum die KI zu einer bestimmten Schlussfolgerung gekommen ist. So kannst du leichter erkennen, ob die Entscheidung auf soliden Informationen basiert oder das Ergebnis einer Halluzination ist.

- Verwendung einfacher Modelle: Komplexe, tief verschachtelte Modelle wie große neuronale Netze neigen eher zu Halluzinationen, weil sie schwer verständlich sind. Nutze, wenn möglich, einfachere Modelle wie Entscheidungsbäume oder lineare Regression, die leichter nachzuvollziehen sind.

- Benutzerfreundliche Visualisierung: Setze auf Tools, die die Ergebnisse und Entscheidungswege der KI verständlich visualisieren. So kannst du verdächtige oder potenziell fehlerhafte Ergebnisse leichter erkennen und analysieren.

Was kann man tun, um die Entwicklung von KI zu verbessern?

Bleib informiert, teile Feedback und setze dich für eine verantwortungsvolle Nutzung von KI ein. Unterstütze Projekte, die sich auf faire und transparente KI-Entwicklung konzentrieren, und nutze KI-Systeme verantwortungsvoll.

Mit einem bewussten Umgang und einer kritischen Haltung kannst du dazu beitragen, dass KI verantwortungsvoll weiterentwickelt wird und ihr Potenzial voll entfalten kann – ohne dabei die Risiken von KI-Halluzinationen aus den Augen zu verlieren.

Wie Forscher das Problem angehen und was für Lösungen entwickelt werden

- Verbesserung der Datenqualität: Eine zentrale Strategie zur Vermeidung von KI-Halluzinationen besteht darin, die Qualität der Trainingsdaten zu erhöhen. Forscher entwickeln Methoden, um fehlerhafte oder verzerrte Daten besser zu identifizieren und zu filtern. Neue Techniken wie automatisierte Datenbereinigung und erweiterte Bias-Erkennung helfen dabei, Trainingssätze zu optimieren.

- Entwicklung robusterer Modelle: Um KI-Modellen mehr Widerstandsfähigkeit gegenüber Halluzinationen zu verleihen, arbeiten Forscher an neuen Modellarchitekturen, die weniger anfällig für fehlerhafte Mustererkennung sind. Dazu gehören hybride Ansätze, die neuronale Netze mit symbolischen Methoden kombinieren, sowie adaptive Modelle, die kontinuierlich aus neuen Daten lernen.

- Explainable AI (XAI) und interpretierbare Modelle: Es wird zunehmend Wert auf die Erklärbarkeit von KI-Modellen gelegt. Neue Ansätze wie „LIME“ (Local Interpretable Model-agnostic Explanations) und „SHAP“ (SHapley Additive exPlanations) ermöglichen es, die Entscheidungsprozesse von KI nachvollziehbar zu machen und Halluzinationen leichter zu erkennen.

- Verwendung von Kontrollmodellen: Forscher entwickeln zusätzliche „Kontrollmodelle“, die speziell darauf trainiert sind, Halluzinationen zu erkennen und zu korrigieren. Diese Modelle überwachen die Ausgabe der Haupt-KI und greifen ein, wenn verdächtige oder unlogische Ergebnisse auftreten.

2. Potenzial von KI trotz ihrer Schwächen

Trotz der Herausforderungen durch KI-Halluzinationen bietet KI ein enormes Potenzial:

- Automatisierung und Effizienzsteigerung: KI kann komplexe Aufgaben schneller und effizienter lösen als Menschen, etwa bei der Datenanalyse, der Mustererkennung oder in der Automatisierung von Prozessen. Sie entlastet Menschen von Routineaufgaben und ermöglicht es ihnen, sich auf kreative und strategische Tätigkeiten zu konzentrieren.

- Innovationen in Medizin und Wissenschaft: In der Medizin hilft KI, Krankheiten frühzeitig zu erkennen, personalisierte Behandlungen zu entwickeln und neue Medikamente zu erforschen. Auch in der Wissenschaft ermöglicht KI Fortschritte durch die Analyse riesiger Datenmengen, die für Menschen unüberschaubar wären.

- Verbesserung der Lebensqualität: Durch KI-gesteuerte Assistenzsysteme und smarte Geräte kann das tägliche Leben erleichtert werden, z. B. durch Sprachassistenten, personalisierte Empfehlungen oder automatisierte Haushaltsgeräte.

3. Dein Beitrag: Wie du die Entwicklung von KI positiv beeinflussen kannst

- Informiere dich und bleibe kritisch: Um die Chancen und Risiken von KI zu verstehen, ist es wichtig, informiert zu bleiben. Lerne über die Funktionsweise von KI, ihre Stärken und Schwächen, und hinterfrage KI-Ergebnisse kritisch.

- Teile Feedback und Bedenken: Nutze Plattformen und Foren, um Feedback zu KI-Anwendungen zu geben. Beteilige dich an Diskussionen über die ethische Nutzung von KI und setze dich dafür ein, dass KI-Systeme transparent und verantwortungsvoll entwickelt werden.

- Unterstütze verantwortungsbewusste Forschung: Fördere Projekte, die sich auf faire und sichere KI-Entwicklung konzentrieren, sei es durch Spenden, freiwillige Mitarbeit oder die Teilnahme an Umfragen. Du kannst auch auf Open-Source-KI-Initiativen achten, die auf Transparenz und Gemeinschaftsarbeit setzen.

- Setze KI verantwortungsbewusst ein: Wenn du selbst KI in deinem beruflichen oder privaten Umfeld nutzt, achte darauf, sie verantwortungsvoll und mit Bedacht einzusetzen. Vermeide es, dich ausschließlich auf KI zu verlassen, insbesondere in Bereichen, die menschliches Urteilsvermögen erfordern.

Fazit

Jetzt weißt du, was KI-Halluzinationen sind und warum sie auftreten können. Auch wenn KI in vielen Bereichen beeindruckende Fortschritte macht, darfst du nicht vergessen, dass sie immer noch ihre Schwächen hat. Es liegt an uns, diese Risiken zu erkennen und damit umzugehen. Sei also wachsam, wenn du KI-Ergebnisse bewertest, und nutze die Tipps, um ihre Zuverlässigkeit zu überprüfen. Hast du selbst schon einmal irreführende KI-Antworten erlebt? Teile deine Erfahrungen in den Kommentaren! Gemeinsam können wir ein besseres Verständnis dafür entwickeln, wie wir KI verantwortungsbewusst einsetzen.

FAQ ´s zu KI-Halluzinationen

Was sind KI-Halluzinationen?

KI-Halluzinationen treten auf, wenn eine Künstliche Intelligenz falsche oder irreführende Informationen generiert, die keinen Bezug zur Realität haben. Das können erfundene Fakten, Bilder oder Aussagen sein.

Warum halluziniert eine KI?

Halluzinationen entstehen oft aufgrund von unzureichenden oder verzerrten Trainingsdaten, fehlerhaften Mustern oder Überinterpretationen durch die KI-Modelle. Auch komplexe Modellarchitekturen können dazu führen.

Wie kann ich KI-Halluzinationen erkennen?

Achte auf unlogische, widersprüchliche oder unerklärlich präzise Aussagen. Überprüfe die Informationen mit verlässlichen externen Quellen und achte auf Konsistenz in den Antworten.

Wie kann ich verhindern, dass eine KI halluziniert?

Verwende hochwertige und vielfältige Datenquellen, bereinige die Daten gründlich und trainiere Modelle gezielt auf Genauigkeit. Setze auch auf erklärbare KI-Modelle, um Entscheidungen nachvollziehen zu können.

Sind alle KI-Modelle anfällig für KI-Halluzinationen?

Grundsätzlich kann jedes KI-Modell halluzinieren, insbesondere komplexe neuronale Netze. Einfachere, transparente Modelle wie Entscheidungsbäume sind weniger anfällig, aber auch weniger leistungsfähig.

Welche Risiken bergen KI-Halluzinationen?

Halluzinationen können zu falschen Entscheidungen führen, insbesondere in sicherheitskritischen Bereichen wie Medizin oder autonomem Fahren. Sie können auch Fehlinformationen verbreiten und Vertrauen in KI untergraben.

Wie arbeiten Forscher daran, KI-Halluzinationen zu verhindern?

Forscher entwickeln robustere Modelle, verbessern die Qualität der Trainingsdaten und nutzen erklärbare KI-Technologien, um die Entscheidungswege der Modelle besser zu verstehen und Fehler frühzeitig zu erkennen.

Gibt es Tools, die mir helfen, Halluzinationen zu erkennen?

Ja, es gibt spezielle Tools wie Explainable AI (XAI) und automatische Faktenprüfungen, die helfen können, die Entscheidungen einer KI nachzuvollziehen und auf ihre Richtigkeit zu überprüfen.